Criar consensos é tarefa urgente diante dos benefícios e riscos da nova tecnologia. Um Observatório poderia detectar novas ameaças. Reunir dados e análises. Orientar políticas nacionais. E evitar que o debate seja capturado por corporações.

O artigo é de Geoff Mulgan, professor de inteligência coletiva, políticas públicas e inovação social na University College London; e Divya Siddarth, cofundadora do Collective Intelligence Project, diretora de pesquisa da Metagov e da Fundação RadicalXChange, pesquisadora associada do Instituto de Ética em IA da Universidade de Oxford, publicado por Outras Palavras, 11-07-2023. A tradução é Maurício Ayer.

Eis o artigo.

Depois de anos negligenciando o desenvolvimento da IA, os governos agora tentam desesperadamente alcançá-la e descobrir como regulá-la. Pelo menos quatro grupos diferentes estão tentando direcionar os argumentos que poderão estabelecer prioridades de governança.

As grandes corporações, não por acaso, desejam assumir o controle da agenda, prometendo que acordos entre elas podem evitar os piores abusos. Embora peçam publicamente por regulação, elas naturalmente querem minimizar quaisquer restrições que possam impedir seus planos e estão trabalhando em propostas que se aplicariam apenas aos principais titulares.

O segundo grupo, os principais especialistas em tecnologia, têm pouco a dizer que seja prático. Embora os estadunidenses aparentemente apoiem uma pausa no desenvolvimento de LLMs [Modelos de linguagem grandes, como o ChatGPT] por uma margem de aproximadamente cinco para um, os especialistas em tecnologia têm poucas (se é que alguma) ideias sobre como essa coisa pode realmente ser implementada; até agora, eles falharam em se envolver seriamente com os dilemas práticos da governança.

O terceiro grupo é composto por governos, que pelo menos foram além da retórica. A União Europeia trabalhou em leis detalhadas que categorizarão a IA de acordo com os níveis de risco e também exigirão que os LLMs explicitem sua natureza, distingam deep fakes de elementos reais, bloqueiem conteúdo ilegal e exijam a identificação de material protegido por direitos autorais usado para treinamento. A maioria dos modelos atuais é configurada para não cumprir esses requisitos. A China, por sua vez, introduziu regras estritas, por exemplo, sobre deep fakes, e criou um regulador potencialmente poderoso na Administração do Ciberespaço da China. O Reino Unido, no entanto, continua esperando que os reguladores existentes possam lidar sem novas leis ou instituições.

Finalmente, há reuniões e órgãos transnacionais, onde ocorrem vagos apertos de mão e uma flagrante falta de propostas reais.

Os historiadores do futuro se perguntarão por que tantas instituições poderosas e comentaristas inteligentes falharam tão lamentavelmente em criar alternativas plausíveis. Inevitavelmente, a maioria dos comentários tenta espremer o problema em estruturas já conhecidas, seja vendo-o como um problema de direitos humanos ou civis, direitos autorais ou leis de concorrência, privacidade e soberania de dados, policiamento e segurança ou crescimento econômico impulsionado pela inovação, com órgãos profissionais querendo enfatizar o treinamento e o credenciamento. Nenhum ainda alcançou a dimensão do desafio de gerenciar uma tecnologia verdadeiramente de uso geral que já está afetando muitas áreas da vida cotidiana.

Embora a IA tenha lentamente se tornado mais visível politicamente – seja na forma de marchas nas ruas de Londres por estudantes em 2020, seja na crise enfrentada pelo governo holandês naquele mesmo ano, graças a um escândalo sobre pagamentos de assistência social, seja ainda pelos numerosos e crescentes exemplos de viés e distorção em algoritmos usados para tomar decisões vitais –, o mundo da política ainda está lutando para estruturar sua resposta.

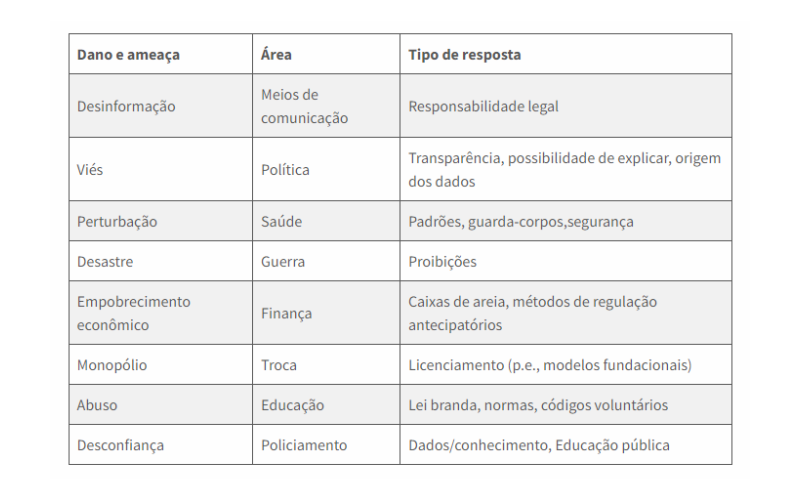

Então, o que pode ser feito? O cenário da governança global de IA tende a ser bastante complexo, com muitos tipos de riscos e oportunidades, muitas áreas envolvidas e muitas respostas de governança possíveis. Reconhecer a complexidade inerente de uma tecnologia de uso geral é o ponto de partida para a ação. Ideias ou soluções unidimensionais tendem a ser inadequadas.

Esta tabela captura algumas das dimensões. Imagine-os como eixos de um cubo tridimensional com muitas centenas de células, cada uma das quais pode exigir uma resposta de governança diferente:

Fonte: Outras Palavras | Reprodução

Dentro de alguns anos, é provável que tenhamos uma rede igualmente complexa de respostas, variando do estabelecimento de padrões às diferentes capacidades de monitoramento, regulações em diferentes níveis, normas legais, medidas antitruste e muito mais. Minha expectativa é de que o mundo crie muitos tipos diferentes de reguladores de IA, muitas vezes com amplos poderes (uma vez que a possibilidade de estabelecer prescrições minuciosas não funcionará, dado o ritmo da mudança) e muitas vezes com a missão de discutir e explicar os dilemas ao público.

O grande paradoxo desse campo baseado em dados é que se sabe muito pouco sobre o que está acontecendo em IA – e o que pode estar por vir. Não existem instituições para aconselhar o mundo, avaliando e analisando tanto os riscos quanto as oportunidades.

Para resolver essa lacuna e iluminar um passo plausível que o mundo poderia tomar agora como condição necessária para uma regulamentação mais séria no futuro, tenho trabalhado com colegas do Instituto de Tecnologia de Massachusetts (MIT), da Universidade de Oxford, do Projeto de Inteligência Coletiva, Metagov e a Cooperative AI Foundation para projetar o que chamamos de Observatório Global de IA (Global AI Observatory, GAIO) para fornecer os dados e as análises necessários para apoiar a tomada de decisões.

O mundo já tem um modelo para isso: o Painel Intergovernamental sobre Mudanças Climáticas (IPCC). Criado em 1988 pelas Nações Unidas com países membros de todo o mundo, o IPCC fornece aos governos informações científicas e julgamento conjunto de cenários potenciais para orientar o desenvolvimento de políticas climáticas. Nas últimas décadas, surgiram muitas novas instituições em nível global que se concentram em dados e conhecimento para apoiar uma melhor tomada de decisão – da biodiversidade à conservação – mas nenhuma existe em torno das tecnologias digitais.

A ideia de criar um órgão semelhante ao IPCC para IA, com a incumbência de fornecer uma base confiável de dados, modelos e interpretações para orientar políticas e tomadas de decisão mais amplas sobre IA, está em andamento há muitos anos. Mas agora o mundo pode estar pronto, graças a uma maior conscientização dos riscos e oportunidades em torno da IA.

Um GAIO teria que ser bem diferente do IPCC em alguns aspectos, tendo que trabalhar muito mais rápido e de maneira mais iterativa. Mas, idealmente, como o IPCC, trabalharia em estreita colaboração com os governos para orientar as ações.

Muitas organizações coletam métricas valiosas relacionadas à IA. Alguns governos nacionais acompanham os desenvolvimentos dentro de suas fronteiras, há empresas reunindo dados do setor e organizações como o Observatório de Políticas de Inteligência Artificial da OCDE mapeiam o que está acontecendo com as políticas e tendências nacionais de IA. No entanto, grande parte das questões relacionadas à IA permanecem opacas, muitas vezes deliberadamente. É impossível para os governos regular de forma razoável aquilo que eles não entendem. O GAIO poderia preencher esta lacuna por meio de seis grandes áreas de atividade.

Em primeiro lugar, poderia estabelecer um banco de dados global e padronizado de relatórios de incidentes, concentrando-se em interações críticas entre sistemas de IA e o mundo real. Um exemplo urgente é o risco biológico, em que há um perigo óbvio de a IA ser usada para criar patógenos perigosos. Precisamos de melhores maneiras de monitorar esses incidentes. Da mesma forma, exemplos de uso indevido de algoritmos – como a recente questão dos pagamentos de seguros sociais – seriam mapeados e documentados. Um banco de dados compartilhado de incidentes e riscos reuniria os fatos relevantes a respeito dos aplicativos, seus impactos e metadados. Ter relatórios de incidentes padronizados é apenas um ponto de partida básico para uma melhor governança global e pode reduzir os riscos de falhas de comunicação e corridas armamentistas em torno da IA.

Em segundo lugar, o GAIO poderia organizar um registro de sistemas cruciais de IA – o que também é uma pré-condição básica para uma governança mais eficaz. Ele priorizaria os aplicativos de IA com os maiores impactos sociais e econômicos – aqueles com o maior número de pessoas afetadas, horas de interação e maiores apostas. Idealmente, também definiria regras para fornecer acesso a modelos que permitam a fiscalização. Cingapura já possui um registro de sistemas de IA e o governo do Reino Unido está considerando algo similar, mas em algum momento abordagens semelhantes precisarão tornar-se globais.

Em terceiro lugar, o GAIO reuniria um corpo compartilhado de dados e análises dos principais fatos relativos à IA: gastos, geografia, campos-chave, usos, aplicativos. Existem muitas fontes para isso, mas ninguém as reuniu em formas facilmente acessíveis, e muitas coisas relacionadas ao investimento permanecem sem transparência.

Em quarto lugar, o GAIO reuniria conhecimento global sobre os impactos da IA em campos específicos, por meio de grupos de trabalho que abordam temas como mercados de trabalho, educação, mídia e saúde. Esses grupos coletariam dados e organizariam interpretações e previsões, por exemplo, sobre os efeitos potenciais dos LLMs em empregos e habilidades, o que está se tornando uma questão crucial em muitos países. O GAIO teria como objetivo coletar dados sobre os impactos positivos e negativos da IA, desde o valor econômico criado pelos produtos de IA até os efeitos potencialmente negativos do impacto da mídia social habilitado pela IA na saúde mental e na polarização política.

Quinto, o GAIO poderia oferecer, aos governos nacionais e talvez também como assistência legislativa, opções para regulação e políticas, fornecendo modelos de leis e regras que possam ser adaptadas a diferentes contextos.

Por último, o GAIO poderia orquestrar o debate global por meio de um relatório anual sobre o estado da IA, que analisaria questões-chave, padrões que surgem e escolhas que governos e organizações internacionais precisam considerar. Assim como o IPCC, isso pode incluir um programa contínuo de previsões e cenários, com ênfase particular em tecnologias que podem entrar em operação ou chegar ao mercado nos próximos anos, com base nos esforços existentes, como o índice de IA produzido pela Universidade de Stanford.

Para realizar seu trabalho, o GAIO precisaria inovar, aprendendo com exemplos como o IPCC e a Plataforma Intergovernamental de Políticas Científicas sobre Biodiversidade e Serviços Ecossistêmicos – mas indo além, inclusive por meio do uso de novos métodos de inteligência coletiva para reunir insumos de milhares de cientistas e cidadãos, o que é essencial para rastrear capacidades emergentes em um campo complexo e em rápida evolução. Além disso, poderia introduzir métodos de denúncia semelhantes aos generosos incentivos do governo dos EUA para que as pessoas denunciem ações prejudiciais ou ilegais.

Para ter sucesso, o GAIO teria que ser legítimo, assim como o IPCC teve que ganhar legitimidade nas últimas décadas. Parte dessa legitimidade pode vir do apoio de governos e parte do endosso de cientistas. Mas muito disso virá da qualidade do que faz e de sua capacidade de manter um foco nítido nos fatos e na análise, mais do que na prescrição, que ficaria nas mãos dos governos. Idealmente, também teria vínculos formais com outros órgãos que têm um papel claro neste espaço, como a União Internacional de Telecomunicações, o Instituto de Engenheiros Elétricos e Eletrônicos, a UNESCO e o Conselho Internacional de Ciência.

A comunidade de IA e as empresas que usam IA tendem a suspeitar do envolvimento do governo, muitas vezes vendo-o apenas como uma fonte de restrições. Mas a era da autogovernança acabou. O que se propõe aqui é uma organização que existiria em parte para os governos, mas com o trabalho principal feito pelos cientistas, aproveitando as tentativas bem-sucedidas de governar muitas outras tecnologias, desde a fertilização humana e a clonagem até armas biológicas e nucleares.

Nos últimos anos, o sistema da ONU tem lutado para lidar com a crescente influência das tecnologias digitais. Criou comitês e painéis, muitas vezes com títulos grandiosos, mas geralmente com pouco efeito. O maior risco agora é que haja uma pluralidade de esforços desconectados, sem que nenhum ganhe força suficiente. A mídia e os políticos foram facilmente distraídos por alegações de risco existencial, e poucos se sentem confiantes para desafiar as grandes corporações, especialmente quando são ameaçadas de cortar seus cidadãos dos benefícios do OpenAI ou do Google.

Portanto, legitimar um novo órgão não será fácil. O GAIO precisará convencer os principais atores dos EUA, China, Reino Unido, UE e Índia, entre outros, de que preencherá uma lacuna vital e precisará persuadir as grandes empresas de que suas tentativas de controlar a agenda, sem qualquer agrupamento de conhecimento e avaliação global, provavelmente não sobreviverá por muito tempo. O argumento fundamental para sua criação é que nenhum país se beneficiará da IA fora de controle, assim como nenhum país se beneficiará de patógenos fora de controle.

A forma como as nações respondem tende a variar. A China, por exemplo, propôs recentemente a proibição de LLMs com “qualquer conteúdo que subverta o poder do Estado, defenda a derrubada do sistema socialista, incite a divisão do país ou prejudique a unidade nacional”. É provável que os EUA desejem o máximo de liberdade.

Mas o conhecimento e a análise compartilhados são certamente a pré-condição para que as nações decidam suas próprias prioridades. A inteligência artificial não gerenciada ameaça nossa capacidade de pensar, agir e prosperar, tornando potencialmente impossível distinguir a verdade da mentira. Reunir conhecimento de maneira inteligente é a pré-condição para aproveitar melhor os benefícios da inteligência artificial e evitar seus muitos perigos.

IHU

https://www.ihu.unisinos.br/630452-e-hora-de-uma-governanca-global-para-a-ia